“`html

Prepare-se para a revolução da inteligência artificial, porque a Meta finalmente revelou o Llama 3.2 no Meta Connect 2024! Esta nova versão promete deixar nossos dispositivos móveis e ambientes de edge computing muito mais legais. A grande sacada por aqui é que agora temos modelos compactos que funcionam localmente em hardwares como Qualcomm e MediaTek, garantindo assim privacidade e eficiência para os desenvolvedores. É como ter um assistente digital que não precisa ficar conversando lá na nuvem o tempo todo!

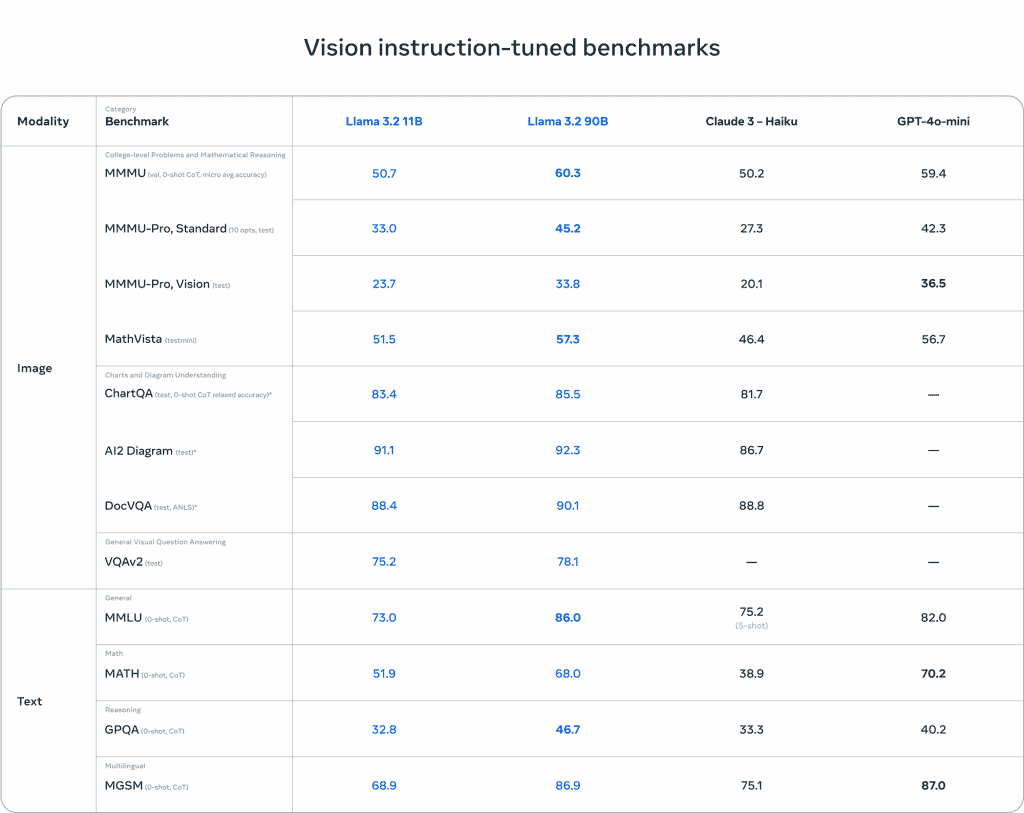

O Llama 3.2 vem equipado com modelos de visão (11B e 90B) e de texto (1B e 3B). Os modelos de visão são como superdetetives que conseguem entender imagens, gráficos e até mapas! Eles são ótimos para tarefas como reconhecimento de imagem e legendagem automática, se colocando como uma alternativa aberta a outras soluções fechadas do mercado.

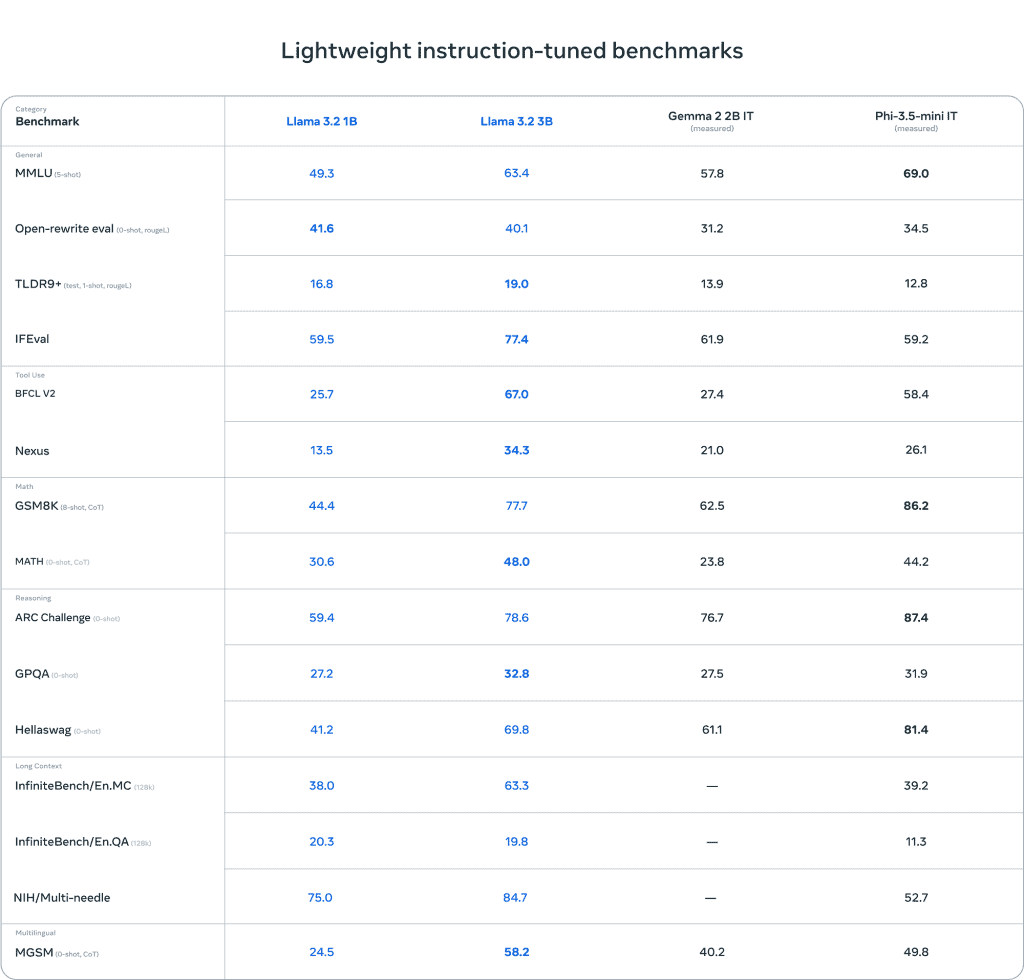

Os modelos de texto, que são mais leves, foram feitos para rodar suave em dispositivos móveis. Eles conseguem lidar com até 128 mil tokens, o que dá para fazer resumos de mensagens, reescrever textos e até seguir ordens sem depender de conexão com a internet. Assim, suas informações ficam bem seguras, já que tudo acontece dentro do próprio dispositivo.

Integração com plataformas parceiras

E não para por aí! A grande novidade vem acompanhada do Llama Stack, um conjunto de ferramentas que facilita a vida de quem quer usar e personalizar os modelos Llama. A Meta se uniu a parceiros como AWS, Databricks, Dell Technologies e Infosys para expandir as aplicações do Llama 3.2 no mundo dos negócios. Isso significa que tem muita coisa boa vindo por aí!

O Llama 3.2 já se integrou diretamente com plataformas como Microsoft Azure, Google Cloud e NVIDIA, e mais um monte de empresas de tecnologia também estão embarcando nessa. É como se a Meta estivesse dando um passeio de mãos dadas com a evolução tecnológica!

Avaliação dos modelos

- Quem testou os modelos de visão do Llama 3.2 notou que eles estão competindo de igual para igual com gigantes como Claude 3 Haiku e GPT4o-mini em reconhecimento de imagens e entendimento visual.

- O modelo de 3B está arrasando e superando concorrentes como o Gemma 2 em várias tarefas, incluindo sumarização e reescrita de prompts.

- O modelo de 1B também mostrou que veio para brigar, sendo competitivo em várias avaliações.

- Nesses testes, foram usados mais de 150 conjuntos de dados em várias línguas, focando nas habilidades visuais dos modelos. Eles realmente se empenharam!

Segurança e responsabilidade

Por último, mas não menos importante, a Meta também anunciou o Llama Guard 3, um sistema de segurança que monitora tudo o que entra e sai dos modelos, garantindo um uso responsável da IA. A Meta está realmente mostrando que se importa com a ética e a segurança ao lidar com suas criações.

Os modelos do Llama 3.2 já estão disponíveis para download e integração com as plataformas dos parceiros. A Meta está apostando em uma abordagem aberta, porque acredita que isso vai agitar a inovação e permitir que desenvolvedores do mundo todo criem novas soluções incríveis com a IA. Vamos ficar de olho!

“`

O post apareceu primeiro em: https://olhardigital.com.br/2024/09/25/pro/meta-lanca-llama-3-2-modelo-aberto-e-customizavel/